第一步:在服务器,下载Ollama镜像,并运行

dockerpullollama/ollama

如果下载速度太慢,可使用我最近上传到阿里云平台上的镜像源,即

dockerpullregistry.cn-hangzhou.aliyuncs.com/damuchacha/ollama:2025-2-18

在root目录下创建ollama目录,然后执行如下命令启动Ollama镜像。

dockerrun-d-v/home/ollama:/root/.ollama-p11434:11434--nameollamaregistry.cn-hangzhou.aliyuncs.com/damuchacha/ollama:2025-2-18

该命令将Ollama服务暴露于主机的11434端口。

第二步:在服务器,ollama环境中运行AI模型

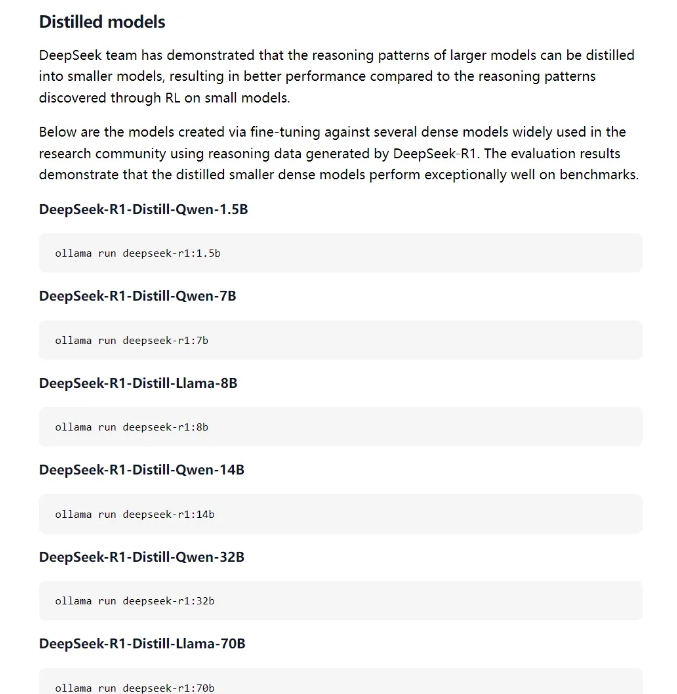

下载AI模型,此处选择的事deepseek-r1版本模型

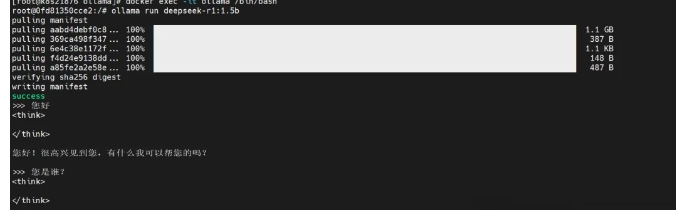

#dockerexec-itollama/bin/bash

#ollamarundeepseek-r1:1.5b

可以根据电脑性能的不同,选择不同版本。可以查看ollama支持的所有大模型

运行结果如下:

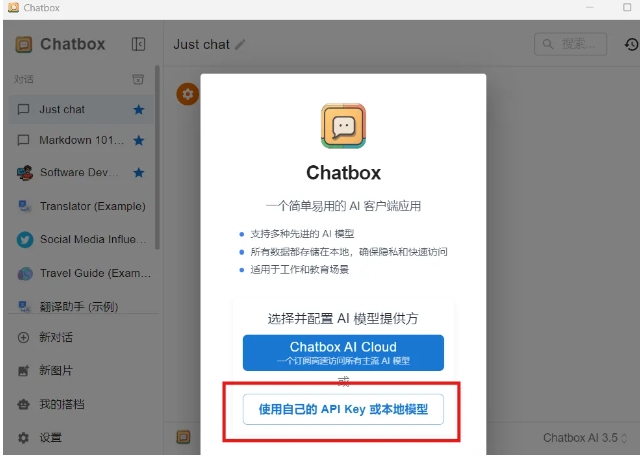

第三步:在客户端,部署桌面应用Chatbox

我的电脑是Windows系统,直接下载该版本安装。选择使用本地模型

使用测试

上一条:Docker基础知识

下一条:以Gurobi优化参数设定之差距最小化技巧详解